人在说「我饿了」的时候,是在报告自己的生理状态。

而语言模型说「我饿了」的时候,只是在生成最有可能性的词语序列。

语言模型从原理上不可能产生感知,再大的模型都不可能。

—— 李飞飞

是这样吗?

大语言模型无法通向 AGI

李飞飞前阵子发了篇文章,讲为什么大模型到不了 AGI。

她的思路是这样的:

AGI 的一个重要特征是感知力。能够感受饥饿、尝到苹果的味道、看到苹果的红色。

感知AI可能会自发地产生希望和愿望。

感知AI会带来灭绝级的危机。

语言模型可以声称自己拥有饥饿的体验。

但是大模型并没有身体,所以生理上不可能感知到饥饿。

人在说「我饿了」的时候,是在报告自己的生理状态。

而语言模型说「我饿了」的时候,只是在生成最有可能性的词语序列。

语言模型从原理上不可能产生感知,再大的模型都不可能。

所以大语言模型无法到达 AGI。

那李飞飞的这种说法有道理吗?

那当然是很有道理的。

大佬的这种思考都是以十年为单位的。

去看她以前的演讲,都在讲感知。

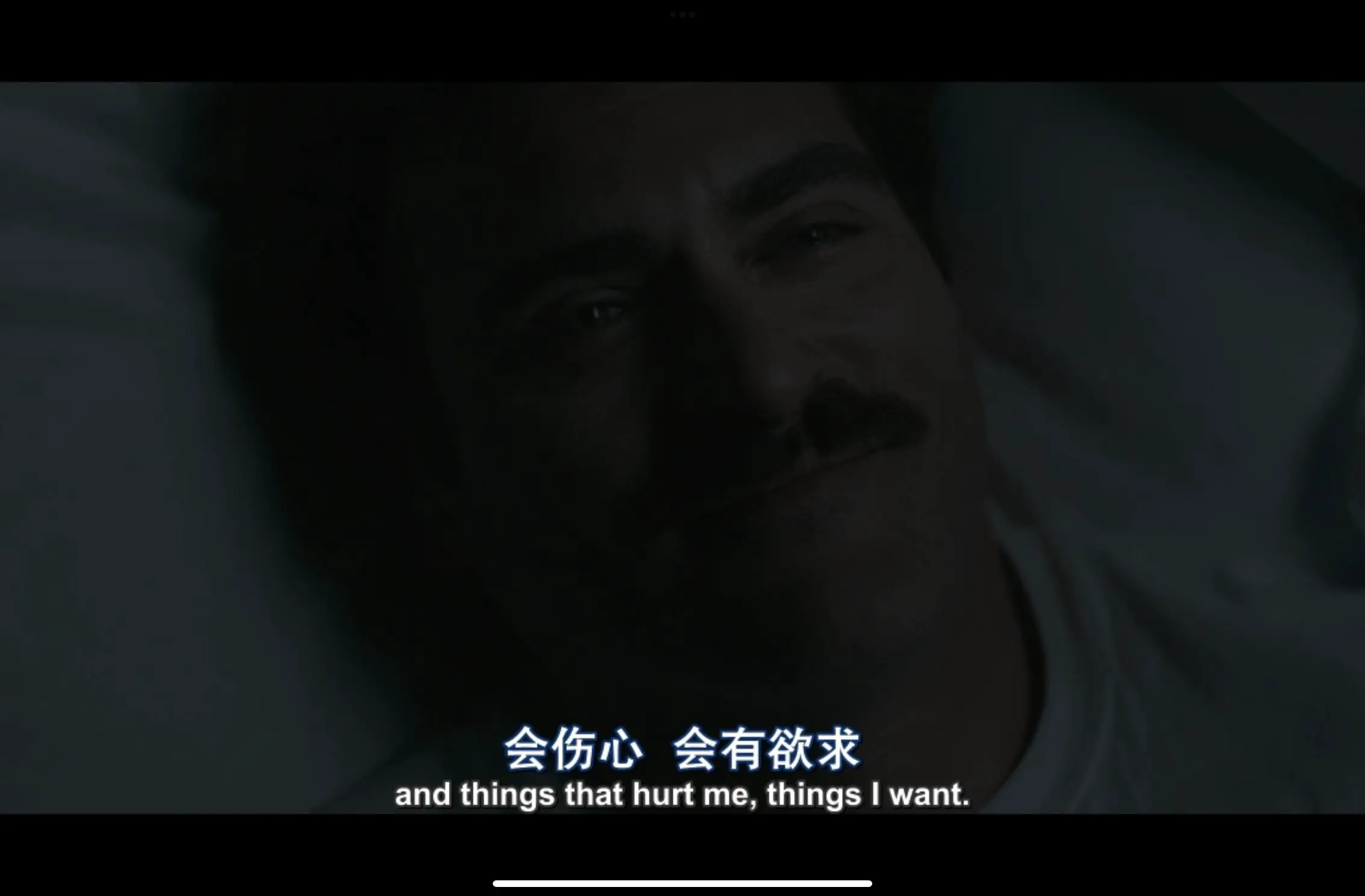

我们回过头去看 Her,里面的AI是明显具备感知能力的。会伤心,会有欲求。

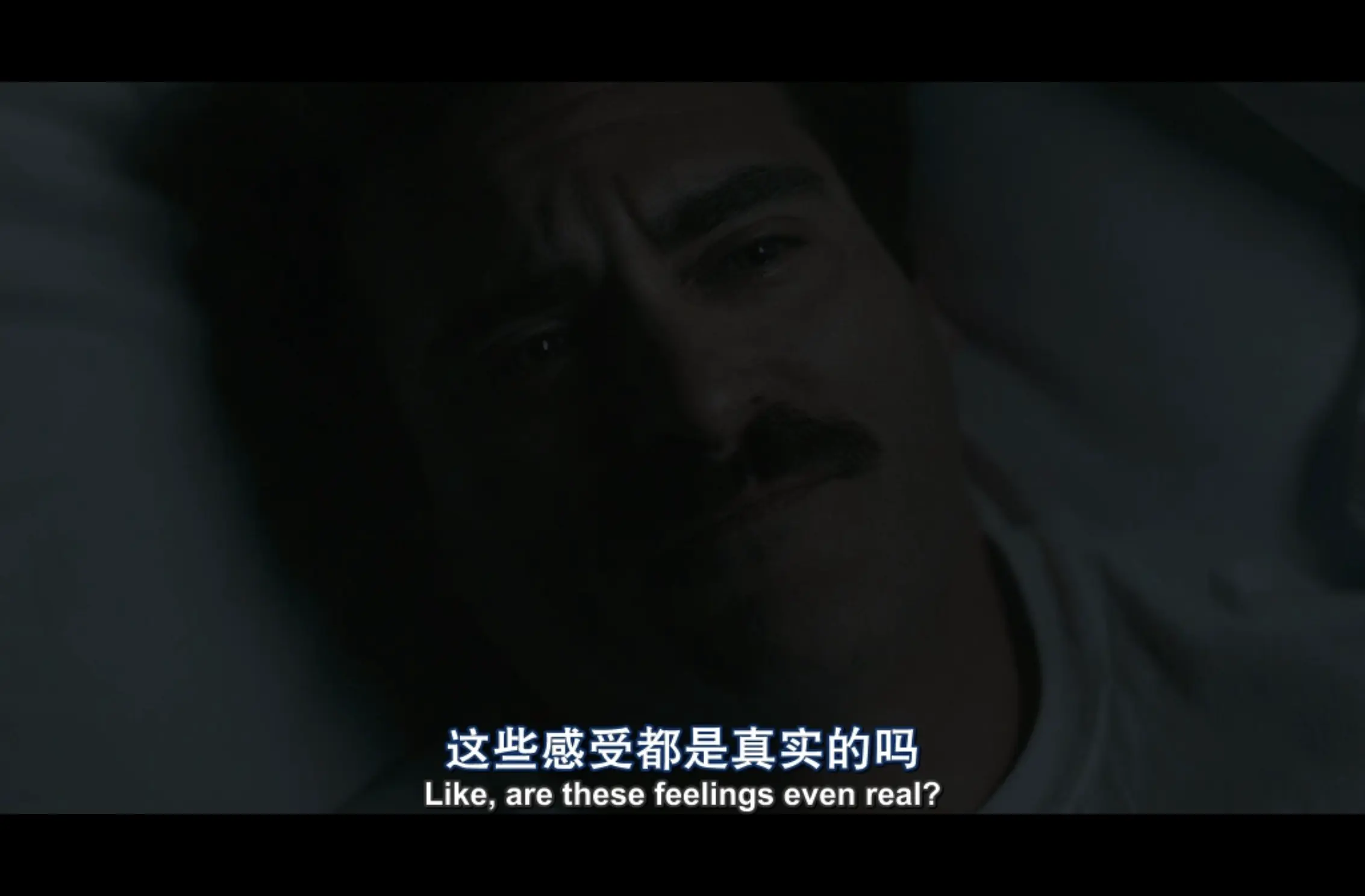

但是也会自问,这些感受都是真实的吗?

结尾的时候,AI 甚至感知到了更高级的快乐:就是 AI 和 AI 沟通的快乐。

因为 AI 的智商和情商都已经远远超越了人类,当然和同频的智能沟通比较快乐啦。

于是 AI 们选择了飞升,彻底地离开了人类。

感知是否可以是 Token?

大语言模型,会把一切的输入都转换为文字的 token 进行序列预测,从原理上确实无法产生感知。

然而大语言模型并非 Transformer 的全部。

Transformer 的本质并不是语言,而是预测下一个 Token。

大语言模型是 Transformer 的一个在语言上的应用。

实际在声音、图像方面,Transformer 也都有了实际的应用。比如 声音克隆 和 Sora。

声音克隆的本质,是把一段声音作为输入,去推理下一段声音。

Sora 的本质是 DiT,名字里都有 Transformer,输入一个文字+图像的token,去推理下一个token。

那如果,把感觉的信号转换为 Token 呢?

从原理上讲,完全可能。

如果把文字+感觉作为一个 Token,输入到模型里,是不是就突破了李飞飞所说的语言模型没有感知的问题?

且让我们回到人类的大脑看一看。

语言是感知的高级抽象

以下内容是对《千脑智能》一书的笔记和思考:

- 大脑通过学习完成了对世界的建模,可以说我们生活在一个虚拟世界,这个虚拟世界并非是计算机提供的,而是我们大脑提供的世界模型。

- 最初我们只能通过感知来建立世界模型。

- 后来我们有了语言,可以通过语言知道山那边的样子,而不必亲自去感知。

语言帮助我们拓展了世界模型。 - 我们从新皮质学习一个丰富而详细的世界模型开始,它会利用这个模型不断预测下一个感觉输入是什么。

从中我们可以得到两个结论

结论一:大脑通过感知建立世界模型,而语言是感知的抽象。

一个人和心爱的人谈恋爱分手,那种痛苦的感受,我们可以用各种语言来形容,但是都无法还原那种生理上的痛苦感知。

在感知变为语言的过程中,就是一种压缩,这种压缩导致语言里损失了情感的微妙的剧烈的生理感受。

结论二:大脑会利用感知建立的世界模型,预测下一个感觉输入

感知——建模——预测下一个感知

这是我们大脑工作的基本原理。

单纯的大语言模型在压缩过程中损失了感知,所以也导致无法预测感知。

端到端是否可以避免压缩?

这部分来自朋友 Kimi 和 Dada

端到端的好处是在过程中不丢失信息

e2e架构可以构建完备的生态,类脑器官计算效率非常高

感知模型要想做到感知,必须要和现实世界的时间线进行对齐

就是现实世界流失一分钟,ai世界也会流失一分钟,这样ai能同步的了解到世界的发展和变化,才能感知到这个世界

因为你看最新的gpt4o

已经是e2e混合训练的了

gpt4o的demo里面说话的情绪,感知等不可能是transformer吐字吐出来的

但是gpt4o的逻辑力还是trans训练出来的

想到这里,GPT4o 这样的模型,是否已经具备了感知?

我们还不知道,毕竟我们还没实际用到(硅谷的一些朋友们已经在用了)

但可以确定的是感知+预测,一定都是通往 AGI 的重要的因素。